Considere duas amostras aleatórias, com 10 observações, retiradas de uma distribuição normal com médias diferentes e mesma variância desconhecida. Para utilizar um exemplo concreto, simulei no R duas amostras, uma de uma normal com média 5 e desvio-padrão 3 e a outra de uma normal com média 2 e desvio-padrão 3.

As amostras resultaram nas seguintes estatísticas:

***

Amostra 1

Média amostral: 5,3

Desvio-padrão amostral: 2,9

Intervalo de 95% de confiança: 3,2 a 7,4

***

Amostra 2

Média amostral: 2,6

Desvio-padrão amostral: 2,2

Intervalo de 95% de confiança: 0,7 a 4,5

***

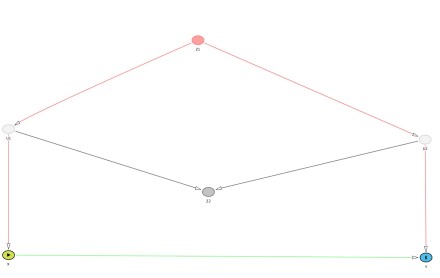

Note que os intervalos de confiança se cruzam. O limite inferior da amostra 1 é 3,2 e o limite superior da amostra 2 é 4,5.

Isso quer dizer que a diferença entre as médias amostrais não é estatisticamente significante a 5%?

Não, fazendo um teste t para a diferença entre duas médias com variância igual você obtém um resultado estatisticamente significante a 5%, com intervalo de 95% de confiança indicando diferenças entre 0,5 a 5. Mesmo supondo que você não soubesse que as variâncias fossem iguais, o teste t de Welch nos dá um intervalo de 95% de confiança para a diferença entre as médias entre 0,1 e 5,3.

Agora imagine que esses dados eram de crescimento de PIB, isto é, um grupo tem média amostral de crescimento de 5,3% e outro de 2,6%. Se você comparasse os intervalos de confiança, você poderia tender a falar que os dois grupos não têm crescimento “diferentes”… quando, na verdade, o próprio teste clássico de diferenças entre médias indica uma diferença entre 0,5 e 5 pontos percentuais, que abarca magnitudes muito relevantes em termos de crescimento econômico!

Mas esse erro acontece?

Sim, no Banco Mundial. No EconBrowser, sobre a controvérsia Reinhart and Rogoff, Chinn divulgou este gráfico relacionando a média de crescimento e o percentual de endividamento público em relação ao PIB. As barras são a média e a linha preta representa o intervalo de 95% de confiança .

Note que, apesar de a média de crescimento dos países com alto endividamento (mais de 90% do PIB) ser bem menor do que a média dos demais, os intervalos de confiança se cruzam. Isso levou o pessoal do blog do banco mundial a dizer que “[…] the confidence intervals of all three bins above the 30 percent debt/GDP threshold also overlap. On this (admittedly crude) basis, then, any claim that a 1 percent growth differential over a decade compounds is simply overstating the case made by the data.”

Isso não é verdade, o simples fato de os intervalos de 95% de confiança cruzarem não quer dizer nada, mesmo se você achasse que significância estatística pura fosse o ponto relevante aqui. Como vimos no exemplo anterior, super simples, os intervalos de confiança podem se cruzar e mesmo assim a diferença ser “estatisticamente significante” e indicar diferenças economicamente relevantes! Cientes do erro, os autores fizeram um postscript alertando para o fato e reduzindo o intervalo de confiança do gráfico para um erro-padrão. O problema é que mesmo nesse caso, se houver alguma forma de dependência entre as amostras (o que provavelmente é o caso), a comparação também não é correta.

Apesar da brincadeira do título, isso não foi uma “burrice” do Banco Mundial. Um problema que tenho encontrado ao discutir estes assuntos é que, em geral, as pessoas acham que somente somente journals de “baixa qualidade” publicam coisas deste tipo. Ledo engano… a incompreensão sobre intervalos de confiança, significância estatística, p-valores é pervasiva nas ciências sociais, inclusive em trabalhos aplicados nas melhores revistas e com os melhores pesquisadores!

PS: como havia dito em post anterior, o risco de escrever em blogs é não ter revisor. Agradeço ao Fábio Gomes por corrigir um erro primário constante na primeira e afobada versão deste post, escrita ontem de madrugada!